问答社区

AI绘画模型算法与推理规则的详细技术解析,包含当前主流模型的运行机制及实现原理

分类:人工智能

以下是关于AI绘画模型算法与推理规则的详细技术解析,包含当前主流模型的运行机制及实现原理:

一、核心模型架构

- 扩散模型(Diffusion Models)

- 前向过程:通过马尔可夫链逐步向图像添加高斯噪声

- 反向过程:学习噪声预测网络εθ

- 训练目标:最小化变分下界(ELBO)

- 前向过程:通过马尔可夫链逐步向图像添加高斯噪声

- 生成对抗网络(GAN)

- 生成器G:将潜在向量z映射到图像空间

- 判别器D:区分真实/生成图像

- 对抗损失函数:

- 生成器G:将潜在向量z映射到图像空间

- 自回归模型(如VQ-VAE)

- 编码器将图像压缩为离散编码

- 使用Transformer进行序列建模:

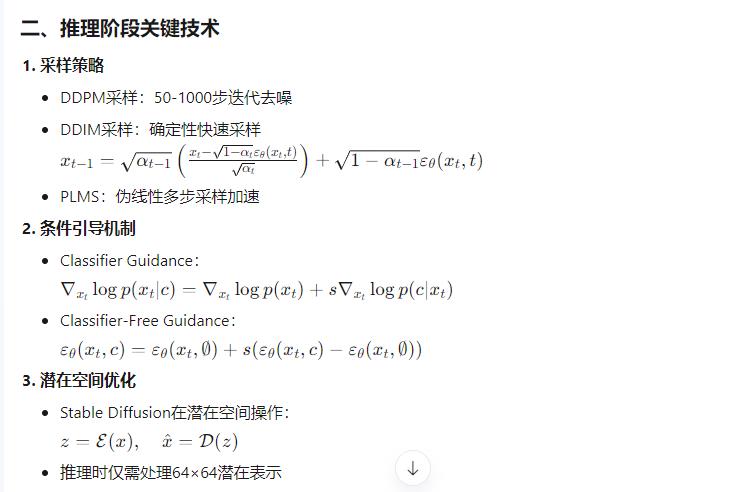

二、推理阶段关键技术

- 采样策略

- DDPM采样:50-1000步迭代去噪

- DDIM采样:确定性快速采样

- PLMS:伪线性多步采样加速

- 条件引导机制

- Classifier Guidance:

- Classifier-Free Guidance:

- Classifier Guidance:

- 潜在空间优化

- Stable Diffusion在潜在空间操作:

- 推理时仅需处理64×64潜在表示

- Stable Diffusion在潜在空间操作:

三、典型模型实现

- Stable Diffusion架构

python复制

# 简化版推理流程 text_encoder = CLIPTextModel.from_pretrained(...) vae = AutoencoderKL.from_pretrained(...) unet = UNet2DConditionModel.from_pretrained(...) latents = torch.randn(batch_size, 4, 64, 64) text_embeddings = text_encoder(prompt)[0] for t in timesteps: latent_model_input = torch.cat([latents] * 2) # classifier-free guidance noise_pred = unet(latent_model_input, t, encoder_hidden_states=text_embeddings).sample noise_pred_uncond, noise_pred_text = noise_pred.chunk(2) noise_pred = noise_pred_uncond + guidance_scale * (noise_pred_text - noise_pred_uncond) latents = scheduler.step(noise_pred, t, latents).prev_sample image = vae.decode(latents / 0.18215).sample - 关键组件

- U-Net结构:包含下采样/上采样块和注意力层

- Cross-Attention机制:融合文本与图像特征

- VAE编码器:将图像压缩至潜在空间(压缩比≈8×)

四、性能优化技术

- 计算加速

- 混合精度训练(FP16/FP32)

- 梯度检查点(Gradient Checkpointing)

- 模型量化(8-bit/4-bit量化)

- 内存优化

- 分块注意力(Memory-Efficient Attention)

- 激活值重计算(Activation Recomputation)

- 推理加速

bash复制

# 使用xFormers加速 pipe.enable_xformers_memory_efficient_attention() # ONNX Runtime优化 torch.onnx.export(unet, inputs, "unet.onnx")

五、评估指标体系

| 指标类型 | 典型指标 | 计算方式 |

|---|---|---|

| 生成质量 | FID (↓) | 比较生成与真实图像的特征分布距离 |

| 多样性 | IS (↑) | 分类器预测结果的熵值 |

| 文本对齐 | CLIP Score (↑) | 图文嵌入空间的余弦相似度 |

| 采样速度 | Iterations/sec (↑) | 单卡每秒处理的采样步数 |

| 内存效率 | VRAM Usage (↓) | 峰值显存占用量 |

六、最新技术演进

- 模型架构创新

- DiT(Diffusion Transformer)

- 3D扩散模型(VideoLDM)

- 控制增强

- ControlNet分支网络

- T2I-Adapter轻量适配器

- 多模态融合

- 多条件联合控制(文本+草图+深度图)

- 跨模态注意力机制

这种技术架构使得现代AI绘画系统能在保持10-20秒/图的生成速度下,输出512×512分辨率的高质量图像。实际应用中需根据硬件条件(如是否拥有A100显卡)和需求(实时性/质量)选择适合的模型变体和采样策略。